Inhalt des Projekts

Das IGF-Vorhaben 19931 N betrachtet den Objektbereich des Fehlermanagements produzierender KMU im Kontext datenbankbasierter Analysemethoden. Durch die zunehmende Vernetzung der Datenlieferanten in digitalisierten Wertschöpfungsketten, beispielsweise im Rahmen der Aktivitäten der Industrie 4.0, bieten sich neue Potenziale und Herausforderungen für das Fehlermanagement, die für KMU erschlossen werden sollten. Insbesondere im Bereich der datenbasierten Verarbeitung und Analyse von Fehlerinformationen besteht Verbesserungsbedarf. Der Forschungsbedarf in den Bereichen „Syntax und Semantik“ sowie „Datenanalyse“ wird insbesondere im Kontext der Industrie 4.0 als groß angesehen.

Für ein zukunftsfähiges Fehlermanagement ist der effektive Umgang mit heterogener Qualitätssensorik wichtig. Die datenbankbasierte Dokumentation und Analyse von Fehlerinformationen bietet die Möglichkeit aus der Gesamtheit bearbeiteter Fehler (Fallbasis) für die Bearbeitung neuer Fehler zu lernen und Fehlerschwerpunkte zu erkennen. Insbesondere KMU lernen aktuell nur unzureichend aus eigenen Fehlern und betrachten Fehler nur auf Einzelfallbasis, ohne ihr gesamtes Fehlergeschehen zu kennen. Signifikante Verbesserungspotenziale werden so nicht erkannt und umgesetzt. Das im Rahmen des Projekts zu entwickelnde Werkzeug soll KMU die Umsetzung eines datenorientierten Fehlermanagements für ein kontinuierliches Lernen aus vergangenen Fehlerfällen ermöglichen.

Wissenschaftlich-technische und wirtschaftliche Problemstellung

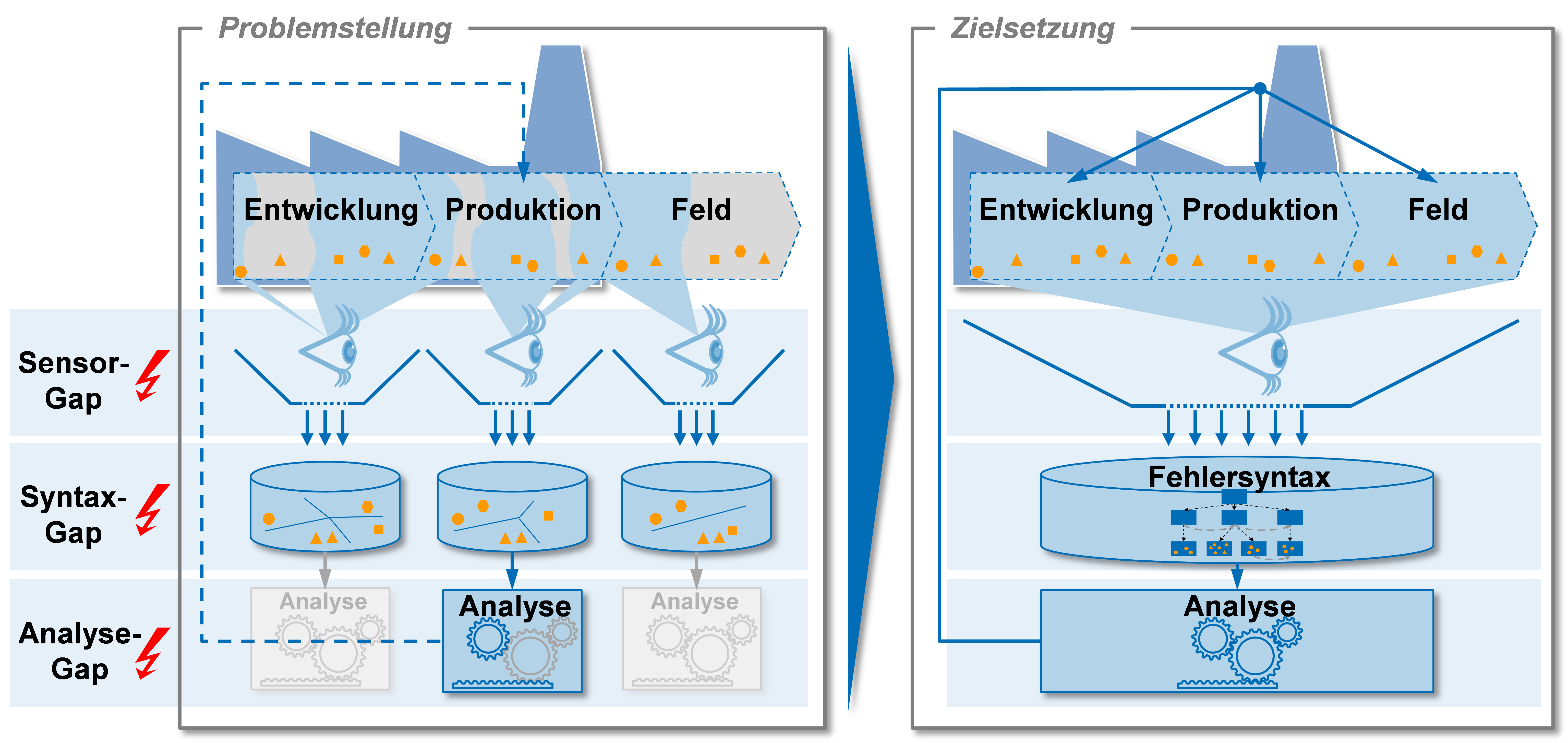

Betrachtet man die Situation des Fehlermanagements detaillierter, können drei Teilprobleme identifiziert werden, die die genannten Lerneffekte verhindern:

Erstens fällt es KMU schwer, ihr gesamtes Fehleraufkommen zu beobachten und zu dokumentieren. Die verwendete Qualitätssensorik, wie Prüfungen im Wareneingang oder am Ende der Produktion, ist zumeist auf den Produktionsprozess beschränkt. Entwicklungsfehler oder Feldfehler werden vielfach nicht erkannt (Sensor-Gap). Dies ist auf eine Produktionsfokussierung der Prüfplanung sowie eine fehlende Systematik bei der Bewertung und Auswahl benötigter Qualitätssensoren zurückzuführen. Qualitätssensoren werden oft unabhängig in einzelnen Bereichen installiert, was eine gesamthafte Betrachtung der Fehlerlandschaft erschwert.

Zweitens führt die fragmentierte Gestaltung der Sensorik zu uneinheitlichen Fehlerbeschreibungen und -strukturierungen. Häufig erfolgt die Fehlerbeschreibung abteilungsspezifisch (z. B.: Entwicklung, Produktion, Vertrieb) nach unterschiedlichen, lokalen Gesichtspunkten, die Form der Strukturierung ist heterogen. Somit sind auch die Fehlerbearbeitung und -analyse abteilungsspezifisch und basieren nicht auf übergreifenden Datenquellen und Erkenntnissen. Die Folge sind Ineffizienzen aufgrund des hohen Aufwands für den Fehlerabgleich zwischen Abteilungen, mehrfacher Bearbeitung von gleichen Themen, Verschwendung aufgrund unnötiger Beschaffung von Schadteilen, entbehrlicher Analysen sowie eines hohen Pflegeaufwands verschiedener Katalogsysteme für die Fehlerbeschreibung (Syntax-Gap). Das Fehlen einer reduzierten und übertragbaren Syntax für Fehlerinformationen und einer einheitlichen Fehlerdatenstruktur macht die Digitalisierung und den abteilungsübergreifenden Austausch von Fehlern unmöglich.

Als drittes Teilproblem ist die Fehleranalyse zu nennen. Insbesondere KMU sind bei der Analyse häufig von wenigen Wissensträgern mit Erfahrungswissen aus vergangenen Fehlerbearbeitungen abhängig. Auch durch die zuvor genannten Teilprobleme fällt es schwer, die Analyse und Maßnahmenidentifikation effizient zu gestalten (Analyse-Gap). Durch die geringe Strukturierung der Ergebnisse und unvollständige Dokumentation wird die Durchdringung des gesamten aktuellen und vergangenen Fehleraufkommens gehemmt und somit Lerneffekte für die Fehlerbearbeitung verhindert. Zudem werden Fehlerschwerpunkte nicht oder mit hohem Zeitverlust erkannt, da ein Überblick über die unternehmenseigene Fehlerlandschaft fehlt. Ansätze zur ressourcenorientierten Steuerung von Fehlerabstellprozessen finden bei KMU kaum Anwendung, da der Aufwand einer manuellen, einzelfallbasierten Bewertung von Fehlern als zu hoch empfunden wird. Ebenso sind analytische Ansätze zur Identifikation von Fehlerschwerpunkten und Etablierung von Lerneffekten im Fehlermanagement selbst nicht verbreitet. Die Abbildung verdeutlicht die genannten Aspekte in der linken Bildhälfte.

Die genannten Teilprobleme verhindern einen stringenten und effizienten Umgang mit Fehlerinformationen bei KMU. Insbesondere die schwache Strukturierung von Fehlerinformationen verhindert die Nutzung automatisierter datenbankbasierter Analyseverfahren. Die Herausforderungen liegen folglich in der gezielten Bereitstellung von Sensordaten (Sensor Gap), einer einheitlichen Strukturierung der Fehlerdaten (Syntax Gap) und der Nutzung von automatisierten Analyseverfahren zur Stärkung der Fehlerbearbeitung und Erreichung personenungebundener Lerneffekte.